News

09.05.2018, 09:09 Uhr

«Hey Google, ruf mal beim Coiffeur an!»

Künstliche Intelligenz und noch einmal künstliche Intelligenz. Und Android P. Diese Neuerungen hat Google an seiner Entwicklerkonferenz vorgestellt.

Ganz im Fokus von Googles Entwicklerkonferenz in Mountain View stand einmal mehr die künstliche Intelligenz. Wie Apple betonte auch Google-Chef Sundar Pichai gleich zu Beginn der diesjährigen «Google I/O» in diesem Zusammenhang etwa die Bedeutung neuer Software-Partnerschaften mit grossen Spitälern. Aber nach einer langen Ausholphase mit interessanten Beispielen wie Sprachfetzenanalyse und Iris-Scans zur frühzeitigen Krankheitsdiagnostik gab es dann noch auch einige spannende Software-Neuigkeiten.

Machine Learning – auch bei Gmail

Ein Kernprodukt für Google sei in diesem Jahr vor allem Gmail gewesen, dem kürzlich eine grössere Design-Renovation zuteil wurde, wobei wir ja eigentlich schon länger nichts mehr von Inbox gehört haben. Um die Bedeutung des neuen Gmails zu unterstreichen, gab es noch ein Software-Zückerchen. So soll nun, während man tippt, mit dem Feature Smart Compose, zumindest in Englisch, die künstliche Intelligenz auch dezent bei der Wortvorhersage helfen.

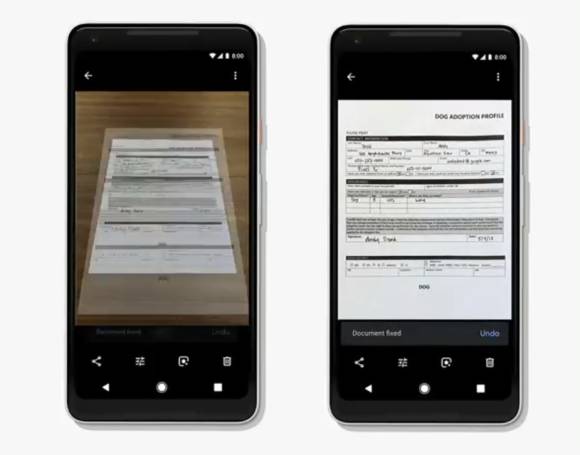

Google Fotos mit automatischen Belichtungen

Ein anderes Produkt, an dem Google mit schlauen Fähigkeiten nachbessert, ist Google Fotos. AI-Systeme sollen die Smartphone-User bald mehr darin unterstützen, automatisch die Helligkeit in unterbelichteten Aufnahmen anzupassen oder gar Schwarz-Weiss-Fotos zu kolorieren. Besonders spannend: Abfotografierte Texte wird der Fotodienst demnächst bei häufiger Suche als Dokumente identifizieren und daher direkt als PDF abspeichern können.

Google Assistant erhält sechs neue Stimmen

Beim Google Assistant sei der Fortschritt ziemlich gross. Laut dem Suchmaschinenkonzern ist der schlaue Gehilfe weltweit schon auf über 500 Millionen Geräten verbreitet und kommuniziere nunmehr mit 5000 Smart-Home-Geräten, obwohl diese Zahl ein wenig hoch gegriffen scheint. Natürliche Aussprache habe man sich dazu sehr zu Herzen genommen. Für sechs neue Google-Assistant-Stimmen etwa wurden beispielsweise nicht neue Sprecher in ein Tonstudio geholt, sondern, natürlich ebenfalls mit ein bisschen Machine Learning, viele Kombinationen von Studioaufnahmen am Computer zusammengeschustert, die automatisch mit KI geformt und vervollständigt wurden.

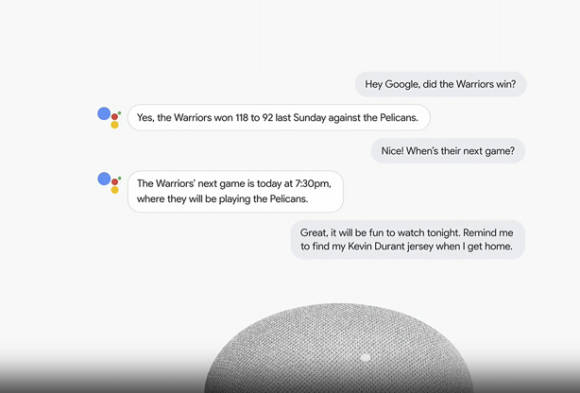

Natürlichere KI-Sprache

Allgemein soll Googles Software-Schlaumeier bei längeren kontextbasierten Dialogen und multiplen Fragen nicht mehr ständig mit «Hey Google» neu zu einer Aktion bzw. Antwort aufgefordert werden. Auch Essen bestellen über Starbucks wird zumindest in den USA schon möglich. Und die Interaktion soll dabei nicht zu kurz kommen, zum Beispiel, wenn man während der Autofahrt und der Nutzung von Google Maps nach Liedern sucht, denn der Google Assistant wird auch enger mit Googles Kartendienst verzahnt. Etwas gespenstisch wirkt da noch ein Feature mit automatisierten Anrufen, um beispielsweise Ladenöffnungszeiten abzuklappern.

Das hat in der Live-Demo sehr natürlich geklungen. Sogar zu Einschüben wie «Hmm ...» ist der Google Assistent demnach in der Lage. Die Google-Stimme kann dann beispielsweise auch mit dem Coiffeur reden, um einen Termin abzumachen. Wie gut das wirklich funktioniert, und ob man dann nicht eine Kahlkopfrasur statt eines Kurzhaarschnitts erhält, wird noch zu überprüfen sein.

Nächste Seite: Das bringt Android P

Das bringt Android P

Das bringt Android P

Android P, der Nachfolger zu Android Oreo, sei mehr als ein Betriebssystem, betonte Google gerne. Auch hier gab es eine geballte Ladung intelligenter Funktionen. Die Rede ist von einem neuen Feature namens Adaptive Battery, das sich beim Akkuverbrauch stärker an die User-Gewohnheiten anpasst. Versprechen will der Konzern aus Mountain View bis zu 30 Prozent mehr Akkulaufzeit. Dabei spiele insbesondere die automatische Helligkeit des Smartphones eine Rolle.

Eine Funktion namens Adaptive Brightness soll sich zudem stärker den persönlichen Helligkeitsgewohnheiten anpassen, sodass man nicht ständig etwas nachregeln müsse. Machine Learning gibt es jetzt auch bei der Vorhersehbarkeit des App-Nutzungsverhaltens, den App Actions. Sucht man zum Beispiel über Google Now nach einem Konzert-Ticket, kann es mit einer häufig genutzten Ticket-Dienst-App gleich gekauft werden. Für Entwickler soll der Aufwand gering sein, da nur eine XML-Datei erforderlich werde.

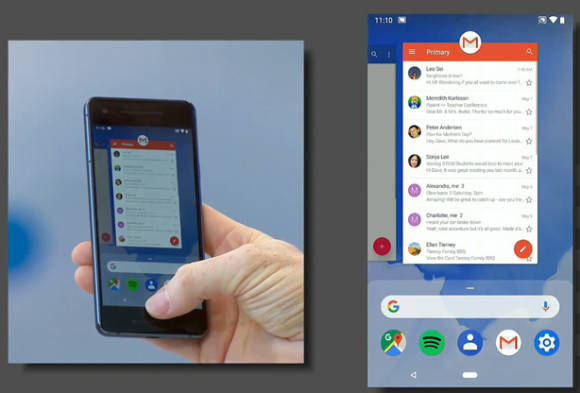

Wischgesten

Ein paar neue Features hat man sich ein wenig vom iPhone X abgeschaut: Ja, auch Wischgesten kommen endlich auf Android. Und die erste Demo sah hübsch aus. So bessert auch der Suchmaschinenkonzern beim Home Button kosmetisch nach. Der App-Drawer, über den man normalerweise alle installierten Apps aufruft, lässt sich in der ersten Beta transparent über die Homescreen-Apps ziehen. Halt, das kennen wir wirklich: Auch kürzlich geöffnete Apps lassen sich nun offenbar mit einer Horizontalgeste wie ein Karussell durchstöbern. Google liess aber nach wie vor noch nichts Näheres zum Status von Android P durchblicken, ausser dass Android P seit gestern im Rahmen des Beta-Programm bereits auf Geräten von sieben Herstellern ausprobiert werden kann.

AR Street View

Sehr vielversprechend klingt eine Augmented-Reality-Funktion für Google Maps. Bei dem Kartendienst soll bald die Kamera die Street-View-Bilder hervorkramen können, wenn man zum Beispiel aus einer Unterführung kommt. So muss man nicht mehr lange überlegen, ob es geradeaus, nach links oder nach rechts geht. Allerdings scheint noch nicht ganz klar, ob es sich dabei erst um eine frühe Tech-Demo handelt. Ausserdem kommt demnächst die Bildanalyse-Software Google Lens auf verschiedene Kamera-Apps und erhält eine Reihe neuer Features, die sich allerdings noch in der Beta-Phase befinden. So muss man zur Nutzung des intelligenten Informationsscanners nicht mehr eine separate App öffnen. Lens wird sogar zum Copy/Paste-Werkzeug von Text aus der realen Umgebung, weil es ähnlich wie Google Translate nun auch Wörter aus der Umgebung erkennt. Wie immer bleibt bei den vielen Neuerungen, speziell beim Google Assistant, der genaue Zeitplan und die Verteilung nach Sprachregion noch abzuwarten.

Fazit

Interessant war zu sehen, wie sich Google vor dem Hintergrund des Facebook-Skandals galant aus politischen Fragen wie Datenschutz heraushielt. Das überrascht nicht ganz bei der Ankündigung der geballten Ladung an Machine-Learning-Features. Sundar Pichai hat nur eingangs betont, dass es natürlich auch bei künstlicher Intelligenz zu False Positives kommen kann, hat dann aber gleich übergeleitet zu den Vorteilen des Einsatzes bei Notfällen wie medizinischer Iris-Analyse oder in Alltagsszenarien wie Sprachanalyse. Die wohl spannendsten Neuerungen beinhalteten für mich die Feature-Flut bei Google Fotos und Google Lens, aber auch die ersten Gehversuche mit Augmented Reality in Google Maps. Ein wenig überrascht hat mich aber dennoch, dass kein Wort zu WearOS, Googles Uhrenbetriebssystem, gefallen ist. Hier wäre dringend ein Update fällig, sonst wird Apple weiterhin den Wearable-Markt fest im Griff haben. Auch zu Google Daydream gab es kein Wort, hat doch Google vor zwei Jahren noch betont, wie schnell man auch zahlreiche neuere Android-Smartphones in das VR-Ökosystem einbinden will.

Kommentare

Es sind keine Kommentare vorhanden.