So entsteht eine Computerstimme

Die Nachbearbeitung der Aufzeichnung

Algorithmus poliert sprachliche Unebenheiten

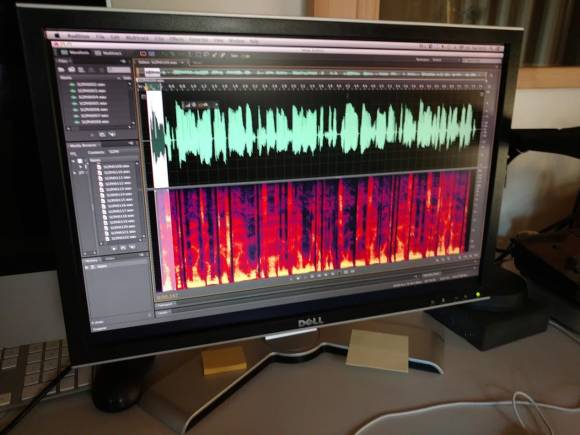

Die riesige Datenmenge zusammenhangsloser Sätze und Wörter rasselt zuletzt im Sprachsynthese-Labor durch einen intelligenten Algorithmus. Das Videoschnitt-ähnliche Programm reduziert die Aufzeichung auf die wichtigsten Wortlaute einer ganzen Sprache und «komprimiert» die Wochenaufnahme auf einen Silbenschwall von acht Stunden. Die Software filtert dabei auch etwaige Unebenheiten, bedingt durch Lispeln oder nasales Sprechen, aus. Der extrahierte Sprachwurm dient bei der Digitalisierung quasi als Inventar der exakten Wortlaute aller vor- oder nachfolgender Silben einer Sprache.

«Ich kann eigentlich auch eine chinesische Stimme selber bauen», lächelt Schnyder. «Das einzige, was ich beherrschen muss, ist die phonetische Schrift», so der Sprachsynthese-Chef. Chinesisch sei aber tatsächlich schwieriger, weil einzelne Wörter je nach Tonlage etwas anderes bedeuten können, entgeget man mir auf meine kritische Frage. Daher unterhalte man in Shanghai ein zusätzliches Labor mit Spezialisten.

Lebendige Wortsilben

Tatsächlich kann sich das Resultat durchaus hören lassen. Johan Wouters tippt für mich in einer Enterprise-Diktier-Applikation längere Sätze in ein Editorfeld. Die Software-Stimme spricht das Getippte in einer kaum monosyllabischen Sprechweise nach. Einzelne Wörter, teils auch komplexere Komposita, werden sehr lebendig gesprochen. Als sässe eine Person direkt vor mir. Trotz meiner Zweifel an der Authentizität der Demo war ich doch für einen Moment sehr verblüfft. Man versicherte mir nachträglich, dass die Demo keineswegs eingespielt war und anlässlich des Tests beliebige Sätze von einer Webseite ins Editorfeld rüberkopiert wurden.

Und die Konkurrenz?

Bei rund 2000 Entwicklern weltweit und einer hauptsächlich B2B-orientierten Geschäftsführung sei Nuance nicht direkt mit Google oder Apple vergleichbar. Als grösste Konkurrenz in der Autoindustrie erachte man die beiden US-Techkonzerne nicht, so Wouters. Man sei stärker darauf ausgerichtet, was Autohersteller als fertige Sprachassistentenz-Software beanspruchen. Die Software verlagere sich dabei je länger je mehr in die Cloud und werde damit auch abhängiger von den mobilen Netzen. Das klassische Software-Geschäft für den Endverbraucher gehöre schon länger nicht mehr zum Kern der Unternehmensausrichtung. «Die Software ist höchstens noch dazu da, um Kunden zu visualisieren, was alles mit dem Endprodukt möglich ist», meint Nuance etwas prahlerisch.

Mal sehen. Mit dem nächsten Smart TV, dem ich auf Weihnachten liebäugle, werde ich aus Neugier wieder einmal aufs Exempel ein paar Worte wechseln. In diesem Bereich will ich die Sprachübermittlung aber gerne in einer sicheren Cloud wissen. Denn für mehr kontextbezogene Informationen muss das System auch mehr Daten seines Anwenders kennen. Deren Auslagerung in eine Cloud sollte von den jeweiligen Herstellern ebenfalls mit schweizerischer Genauigkeit geplant sein.

Kommentare

Es sind keine Kommentare vorhanden.