KI lokal nutzen

LM Studio

LM Studio ermöglicht es Ihnen, diverse KI-Modelle wie Llama, Mistral und Phi auf dem eigenen Rechner auszuführen. Auch die kürzlich von OpenAI veröffentlichten Varianten von ChatGPT gehören dazu, ebenso DeepSeek aus China. Wählen Sie die am besten geeigneten Modelle für Ihre jeweiligen Aufgaben. Neben der reinen Chatfunktion können Sie auch lokale Dokumente einbinden und analysieren lassen.

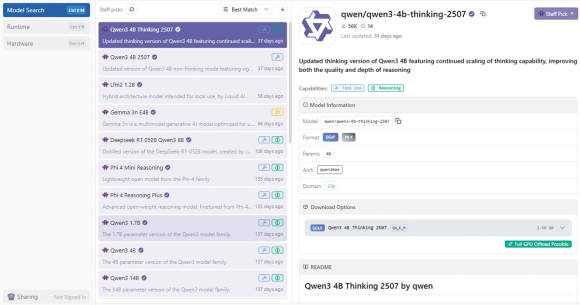

Surfen Sie zu der Website lmstudio.ai, laden Sie LM Studio herunter und installieren Sie es. Nach dem ersten Start sind noch keine Modelle vorhanden. Klicken Sie auf das Lupen-Symbol, um zu einer Liste der verfügbaren Modelle zu gelangen. Sie ist sehr lang, Bild 1.

Bild 1: LM Studio kennt unzählige KI-Modelle, die sich sogleich herunterladen lassen

Quelle: PCtipp.ch

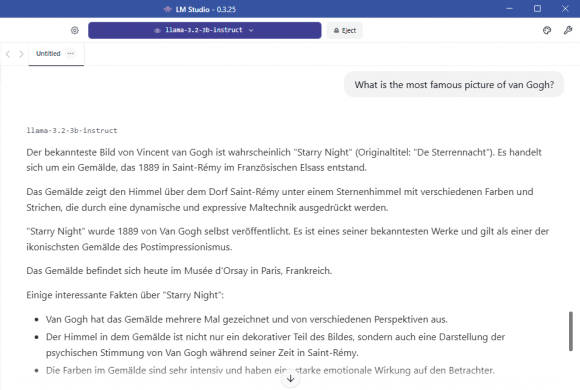

Bild 2: Llama 3.2 von Meta ist ein fortschrittliches KI-Modell, das auf Fragen sehr ausführlich antwortet

Quelle: PCtipp.ch

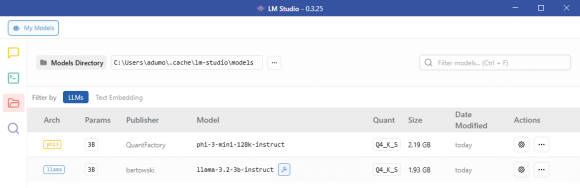

Bild 3: Unter My Models sehen Sie, welche Modelle installiert sind, und in welchem Ordner sie sich befinden

Quelle: PCtipp.ch

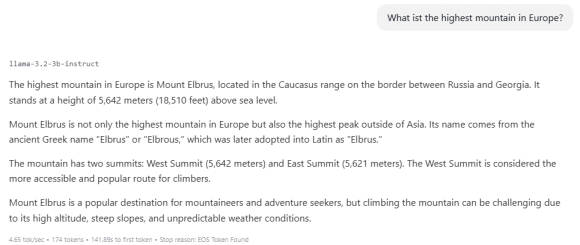

Bild 4: LM Studio stellt eine Bedienoberfläche bereit, in der Sie mit dem ausgewählten KI-Modell kommunizieren

Quelle: PCtipp.ch

Um weitere Modelle zu installieren, klicken Sie auf den Button mit dem Lupen-Symbol. In der Liste der empfohlenen Modelle befindet sich auch DeepSeek-R1-0528-Qwen3-8B.

Dabei handelt es sich um ein Distill-Modell. KI-Distillation ist ein Verfahren, bei dem das Wissen grosser KI-Modelle (Lehrermodelle) auf kleinere, effizientere Modelle (Schülermodelle) übertragen wird. Ziel ist es, die Leistung der grossen Modelle zu bewahren und gleichzeitig Rechenaufwand, Energieverbrauch und Hardware-Anforderungen drastisch zu reduzieren. Dennoch schlägt das Modell mit rund 5 GB zu Buche.

Weitere gute Modelle sind Phi, Hermes und Mistral. Sie stehen in zahlreichen Versionen zur Verfügung. Schauen Sie, welche am besten zu Ihrer Hardware passt. Ein vergleichsweise anspruchsloses Modell ist zum Beispiel Phi-3-mini-128k-instruct-GGUF mit gut 2 GB. Über das lilafarbene Feld am Seitenkopf wählen Sie aus, welches Modell Sie aktuell verwenden wollen. Wenn Sie in das Suchfeld GPT eingeben, finden Sie auch die OpenAI-Modelle gpt-oss-20b-GGUF und gpt-oss-120b-GGUF. Ersteres kommt auf 12 GB, letzteres auf 62 GB. Der Einsatz ergibt nur auf leistungsstarken Rechnern einen Sinn.

02.12.2025

03.12.2025

06.12.2025