KI lokal nutzen

Llamafile

Llamafile beschreitet einen etwas anderen Weg. Das Tool ermöglicht es, KI-Modelle in einer einzigen ausführbaren Datei zu verpacken und lokal und damit komplett anonym auf dem eigenen Computer zu nutzen. Anders gesagt: Llamafile kann die öffentlich verfügbaren Gewichte von grossen Sprachmodellen in eine ausführbare Datei konvertieren.

Das klingt unspektakulär, eröffnet aber ungeahnte Möglichkeiten. Die Gewichte, die bei den Open-Source-Modellen meist frei verfügbar sind, sind vereinfacht gesagt die Parameter oder Einstellungen des Modells, die dafür sorgen, dass es gute Antworten gibt. Es handelt sich dabei in der Regel um riesige Dateien, die man so nicht einfach benutzen kann.

Es gibt mehrere Möglichkeiten, wie man die KI-Modelle mit Llamafile verwenden kann. Direkt auf der GitHub-Seite von Llamafile finden Sie unter dem Abschnitt Quickstart die einfachste Möglichkeit: Sie können hier eine fertige Datei, ein Llamafile, herunterladen und direkt ausführen, um die KI zu nutzen.

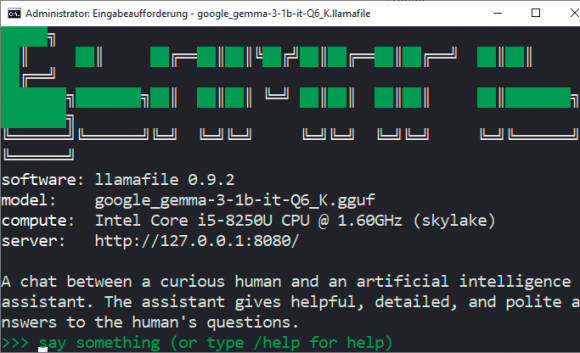

Surfen Sie zu github.com/Mozilla-Ocho/llamafile und laden Sie etwa das Modell Gemma 3 1B Instruct herunter. Die dazugehörige Datei heisst google_gemma-3-1b-it.Q6_K.llamafile. Ändern Sie den Dateinamen, indem Sie ein .exe anhängen. Öffnen Sie die Eingabeaufforderung: Drücken Sie Windowstaste+R, geben Sie cmd in das Ausführen-Feld ein und drücken Sie Enter. Dort navigieren Sie zum Llamafile, indem Sie cd C:\Users\[IhrBenutzername]\Downloads eingeben. Rufen Sie das File mit folgendem Befehl auf: .\google_gemma-3-1b-it-Q6_K.llamafile.exe

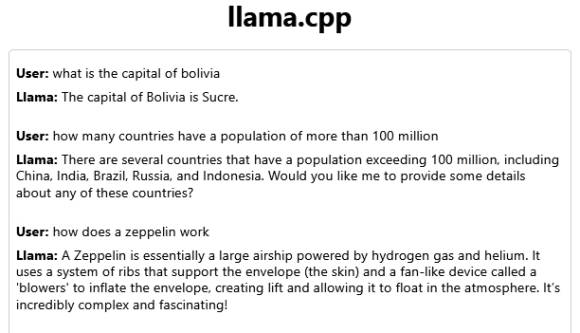

Nach einigen Sekunden startet das Modell in der Eingabeaufforderung, Bild 5. Sie können es ausserdem im Webbrowser via http://localhost:8080 nutzen. Tragen Sie zum Beispiel im Webbrowser Ihre Frage wie «What is the capital of Bolivia?» in das Eingabefeld ein und klicken auf Send. Gemma benötigt wenige Ressourcen und liefert sofort eine Antwort, ist aber nicht immer aktuell. Zum Beenden verwenden Sie in der Eingabeaufforderung die Tastenkombination Ctrl+C, Bild 6.

Bild 5: Llamafiles laufen in der Eingabeaufforderung und lassen sich auch dort bedienen

Quelle: PCtipp.ch

Bild 6: Llamafiles sind KI-Modelle als ausführbare Dateien; sie lassen sich bequem im Browser bedienen

Quelle: PCtipp.ch

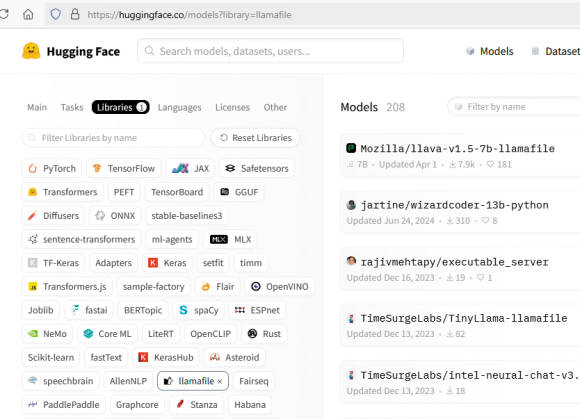

Bild 7: Auf der Webseite von Hugging Face stehen mehr als 200 Llamafiles bereit

Quelle: PCtipp.ch

02.12.2025

03.12.2025

06.12.2025